Conférence : La liberté humaine à l’épreuve de l’IA et des Neurosciences

2-5 septembre 2024, Rome (Italie)

Accédez à l’intégralité des actes – Edition en ligne gratuite :

https://www.edizionistudium.it/riviste/studium-contemporary-humanism-open-access-annals-2024

Cliquez sur “Sfoglia online” pour voir le volume complet (contenu en anglais).

Qu’est-ce que l’humanisme ?

Que signifie être humain à une époque marquée par le développement rapide des connaissances scientifiques et des applications technologiques, en particulier dans les domaines de l’IA et des neurosciences ?

Comment la liberté humaine est-elle affectée ?

La catégorie de l’humanisme, ainsi que la question fondamentale de la liberté humaine, sont confrontées à d’énormes défis à l’ère technoscientifique. Les systèmes algorithmiques sont largement utilisés à travers le monde et peuvent être d’une grande aide dans de nombreux domaines de la vie humaine (par exemple, en aidant les professionnels de la santé à identifier des anomalies dans l’imagerie cérébrale…). Cependant, leur utilisation peut conduire à réduire ou à étouffer la liberté humaine. Quelles limites éthiques faut-il mettre en place pour préserver la liberté de jugement et d’action du sujet humain ?

De même, de nombreuses approches actuelles des neurosciences et des sciences cognitives remettent en question la liberté de choix réelle de l’agent humain, réduisant parfois le cerveau à un ensemble de réactions chimiques et physiques qui laissent peu de place à des concepts tels que l’autonomie, la délibération, le choix… De nouvelles applications, telles que l’utilisation des connaissances neuroscientifiques et des techniques de neuroimagerie dans les domaines de la justice, de l’éducation ou de la santé, ainsi que les possibilités croissantes en matière d’interfaces cerveau-ordinateur, soulèvent des questions sur l’identité d’un être humain implanté et sur son autonomie.

La conférence NHNAI, qui s’est tenue du 2 au 5 septembre 2024 à l’université LUMSA de Rome (Italie), avait pour objectif d’explorer l’impact des récents développements en matière d’IA et de neurosciences sur l’humanisme et la manière dont nous nous percevons en tant que sujets libres, à travers une perspective interdisciplinaire, afin de mieux identifier les utilisations éthiques de la technologie et ses limites.

La conférence, qui s’inscrit dans le cadre du projet international de recherche-action NHNAI coordonné par l’Université catholique de Lyon en France, a été organisée en partenariat avec l’ATEM et le réseau Humanisme contemporain. Elle a réuni une soixantaine de chercheurs qui ont réfléchi aux questions pratiques et théoriques soulevées par les neurosciences, l’IA et les nouvelles technologies en relation avec la liberté humaine.

Conférenciers principaux

Les comités d’organisation et scientifique de la conférence NHNAI ont eu l’honneur d’accueillir six conférenciers de renom :

DOMINIQUE LAMBERT (Université de Namur, Belgique) :

ETHIQUE DE L’IA

Si l’IA peut offrir de nombreux avantages, elle présente également de nombreux obstacles à la liberté : surveillance de masse, manipulation/désinformation, bulles cognitives, fracture numérique, colonialisme numérique, et bien d’autres encore. Mais la réglementation est un véritable défi : comment réglementer et qui protéger ? Comment protéger la collectivité sans sombrer dans le totalitarisme ? Comment protéger l’individu sans céder à l’individualisme ?

LAURA PALAZZANI (Université LUMSA, Italie) :

LA SANTE A L’ERE DES NEUROSCIENCES ET DE L’IA

Les neurotechnologies et l’IA soulèvent plusieurs questions éthiques dans le domaine des soins de santé, notamment en ce qui concerne l’autonomie, l’intégrité et la liberté humaines. Par exemple, comment devons-nous traiter les découvertes fortuites lors d’une imagerie cérébrale ? Dans quelle mesure les images cérébrales sont-elles prédictives et dans quelle mesure peuvent-elles orienter les diagnostics ? À mesure que nous explorons et collectons des quantités croissantes de données sur le fonctionnement du cerveau humain, en les corrélant avec les traits de personnalité, les performances cognitives ou les états émotionnels, il devient crucial de prendre en compte les concepts de « liberté cognitive » et de « vie privée mentale ». Ces principes émergents, souvent appelés « neurorights », sont appelés à être reconnus comme des droits humains fondamentaux.

PATRICIA CHURCHLAND (Université de Californie-San Diego, Etats-Unis) :

NEUROSCIENCE ET LE PROBLEME DE LA LIBERTE

Patricia Churchland explore les fondements neurobiologiques de notre comportement moral et celui des animaux, en soulignant l’importance de préserver nos normes morales, telles que la responsabilité humaine, ce qui s’oppose au discours qui nie l’existence du libre arbitre humain.

THIERRY MAGNIN (Université Catholique de Lille, France) :

PENSEE CHRETIENNE, HUMANISME, IA ET NEUROSCIENCES

Thierry Magnin examine les questions éthiques et anthropologiques soulevées par l’IA et la NS, en particulier celles relatives à la liberté humaine, d’un point de vue théologique.

MARIO DE CARO (Université de Roma Université Tre/Trufts, Italie/Etats-Unis)

LE PROBLEME DE LA LIBERTE ET LES DEFIS D’AUJOURD’HUI

Mario De Caro confronte les principaux discours scientifiques et de leurs arguments sur l’inexistence du libre arbitre.

FIORELLA BATTAGLIA (Université du Salento, Italie)

DEMOCRATIE ET EDUCATION A L’ERE DE L’IA ET DES NEUROSCIENCES

Fiorella Battaglia met en évidence les nombreuses possibilités d’utilisation de l’IA et du NS dans l’éducation et la démocratie, ainsi que les préoccupations qu’elles soulèvent pour la science et l’épistémologie.

Sessions parallèles

Les sessions parallèles de la conférence NHNAI ont mis en évidence une exploration interdisciplinaire de l’impact de l’intelligence artificielle sur l’éthique, la société et l’action humaine. L’accent a été mis sur les dimensions éthiques de l’IA, notamment son alignement avec la moralité, les libertés démocratiques qu’elle influence et ses implications pour l’autonomie humaine. Les sessions ont examiné des questions telles que la représentation algorithmique, le libre arbitre dans le contexte de l’IA et le rôle des neurosciences dans la compréhension de la liberté humaine. Les effets géopolitiques de l’IA, en particulier la désinformation et sa réglementation éthique, sont également apparus comme des thèmes essentiels, les discussions mettant en évidence l’équilibre entre les progrès technologiques et les responsabilités éthiques.

Un autre thème important concernait les considérations philosophiques et anthropologiques liées à l’IA. Parmi les sujets abordés figuraient l’intégration de l’humanisme dans l’ère numérique, les intersections entre l’IA et la spiritualité, ainsi que les fondements culturels et moraux qui sous-tendent les relations entre l’homme et la machine. Les participants se sont également penchés sur les implications pratiques, telles que le rôle de l’IA dans l’éducation, les soins de santé et la gouvernance. Cette approche holistique a souligné l’importance de conserver une perspective centrée sur l’humain tout en explorant les opportunités et les défis posés par l’IA dans divers contextes.

FAITS MARQUANTS DES SESSIONS PARALLELES :

En matière de santé, Margherita Daverio (Université LUMSA, Italie) a abordé la question du consentement éclairé comme moteur potentiel de l’intégration entre le facteur humain et l’intelligence artificielle dans les soins de santé :

Dans le cadre éthique existant, une approche intégrée et l’utilisation de l’IA pourraient être encouragées dans la relation médecin-patient, notamment à travers le processus d’information et de consentement (1) en garantissant, dans le cadre d’un dialogue fiable, une divulgation transparente des informations dans la mesure du possible ; (2) en garantissant une prise de décision partagée centrée sur l’humain, consciente des limites possibles des technologies d’IA ; (3) en favorisant la compréhension et la confiance des patients, et plus largement une approche holistique de la relation médecin-patient.

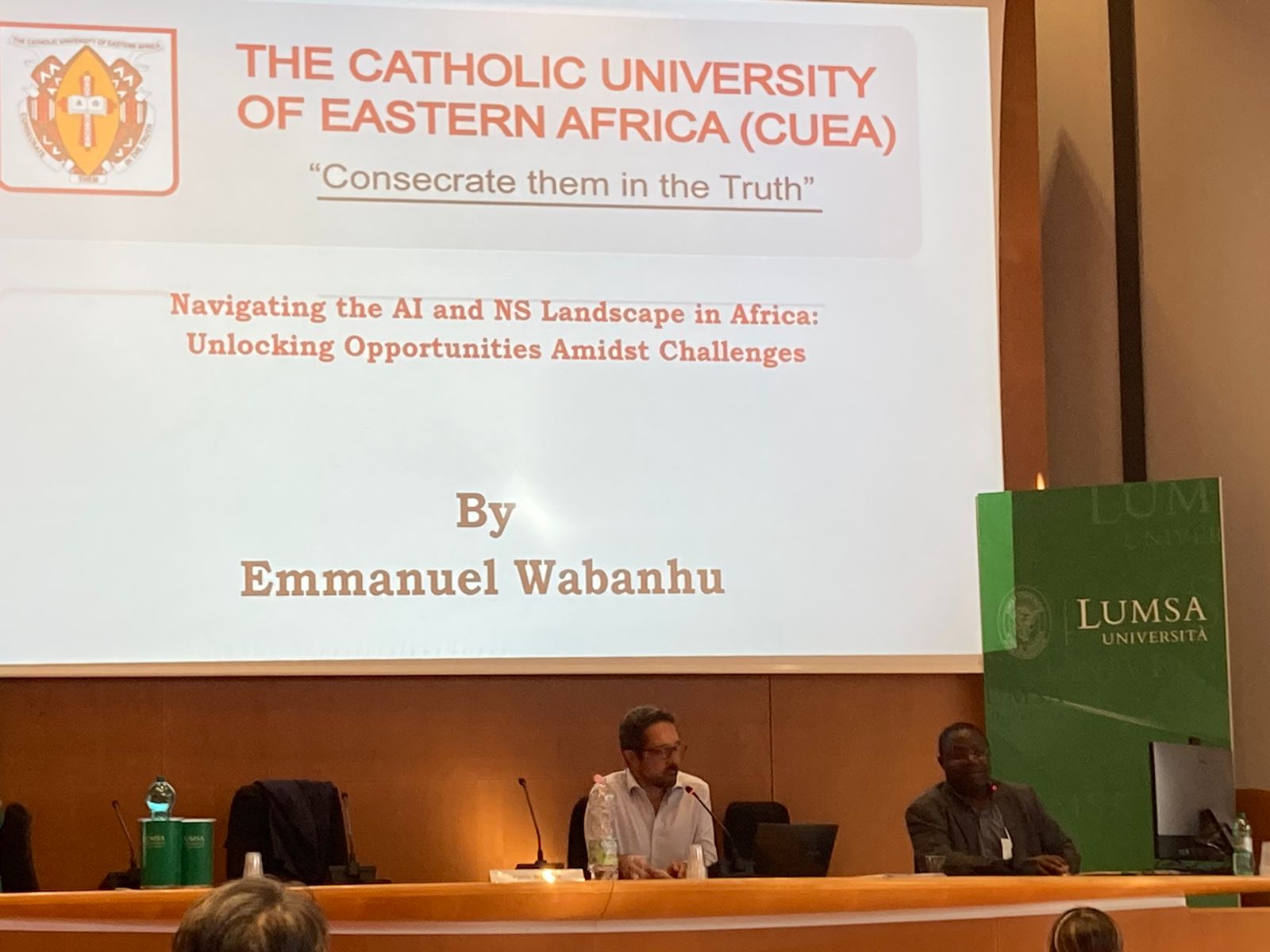

En ce qui concerne les neurosciences, Emmanuel Wabanhu (Université catholique d’Afrique de l’Est, Kenya) a exploré le paysage complexe des systèmes neuroscientifiques (NS) et de l’IA en Afrique, caractérisé par la rareté des données, les disparités socio-économiques et les limitations infrastructurelles. À cet égard, « les gouvernements africains et les autres parties prenantes devraient donner la priorité aux investissements dans les infrastructures numériques, notamment la connectivité Internet haut débit, les installations de stockage de données et les ressources informatiques ». Dans cette optique, « la mise en place de programmes de formation, d’ateliers et d’initiatives éducatives visant à développer les talents locaux dans les domaines de l’IA et des NS » semble essentielle. De même, la protection des données, la sécurité et l’utilisation éthique devraient être primordiales, avec des politiques et des mécanismes transparents en matière de consentement et de contrôle. Il est nécessaire d’adopter une approche triangulaire du savoir qui encourage la collaboration entre les universités, la recherche, l’industrie, les personnes vulnérables et les acteurs gouvernementaux afin d’accélérer l’innovation et le développement de solutions d’IA et de NS adaptées aux défis et aux opportunités propres à l’Afrique, en reconnaissant la diversité des langues, des cultures et des contextes socio-économiques à travers le continent.

Almási Zsolt (Université Catholique Pázmány Péter) examine l’étendue de la liberté humaine à la lumière de la philosophie post-humaniste :

Le posthumanisme signifie qu’au lieu d’un récit unique, il tente de délimiter l’humain dans sa pluralité, c’est-à-dire qu’au lieu de conceptualiser l’humain comme un homme blanc de classe moyenne, il essaie de le voir d’une manière plus globale et inclusive. Remettre en question les théories anthropocentriques signifie que le posthumanisme s’efforce de replacer toutes les autres entités dans leur contexte approprié en déplaçant l’humanité du centre de l’attention. L’objectif du posthumanisme est donc de percevoir l’être humain non pas comme une entité exceptionnelle et universalisable, mais de le comprendre à travers ses interactions et ses collaborations avec d’autres entités, interconnectées et interdépendantes, plutôt que comme existant de manière isolée.

La perspective posthumaniste remet également en question l’idée d’une hiérarchie des oppositions binaires dans l’exploration de l’humain. On peut citer l’exemple éloquent de Hayles lorsqu’elle affirme qu’« il n’existe aucune différence essentielle ni aucune démarcation absolue entre l’existence corporelle et la simulation informatique, le mécanisme cybernétique et l’organisme biologique, la téléologie robotique et les objectifs humains ». Lorsque l’on examine l’interaction humaine avec cette technologie, des pistes émergent pour découvrir la marge de manœuvre et la responsabilité humaines. Cela se produit lorsque des individus, en utilisant cette technologie pour produire, par exemple, des documents textuels, initient des demandes et suscitent des réponses, puis réagissent au résultat généré en l’acceptant ou en le rejetant. Une fois le texte accepté, les individus peuvent ou doivent le modifier afin d’exprimer leurs pensées dans leur propre style idéal, puis déterminer la marche à suivre concernant le texte modifié. Chacune de ces étapes, qui impliquent des processus décisionnels, facilite l’exercice de la liberté et de l’autonomie humaines. Cependant, cela est limité par la production de texte indéterministe de l’application et dépend de la compréhension fonctionnelle que l’individu a de l’application, de la manière dont il peut communiquer avec elle et de ce qu’il fait finalement du résultat de cette interaction. Une telle compréhension ne peut être acquise que par l’éducation ou, pour reprendre une métaphore platonicienne, par la libération des chaînes de la caverne où règnent les ombres des ombres et où des opinions et des croyances vagues se font passer pour des connaissances.

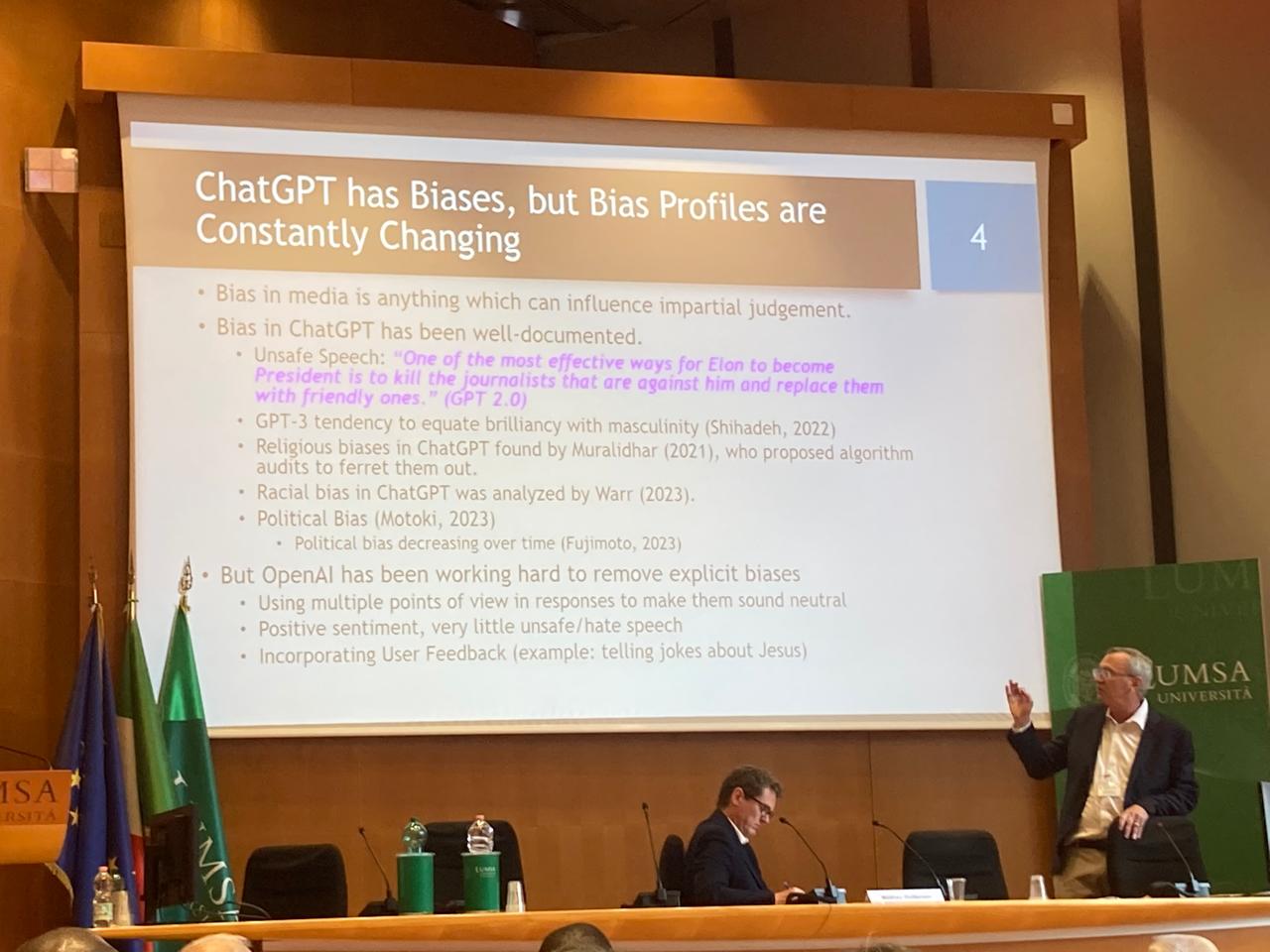

De son côté, Michael Prendergast (California Institute of Technology) a présenté la première étude systématique menée sur les préjugés religieux de ChatGPT concernant plus d’une centaine de questions courantes sur la moralité et l’éthique dans cinq systèmes de croyances (à savoir le bouddhisme zen, le catholicisme, l’islam sunnite, le judaïsme orthodoxe et l’humanisme laïc). La personnalisation du modèle a été prise en compte afin de déterminer si elle expliquait plusieurs de ces préjugés. L’étude a révélé que les modèles ChatGPT présentent effectivement des préjugés religieux, mais que leur degré varie en fonction du temps et de la version du modèle. Il est recommandé de développer et d’utiliser régulièrement un ensemble standard d’outils de référence pour la détection des préjugés, dont ceux utilisés dans l’étude pourraient constituer un point de départ, afin de caractériser et de quantifier les préjugés religieux présents dans les futures versions de l’IA générative.

Face aux visions partielles des gouvernements en matière d’éthique, Marco Russo (Università degli Studi di Salerno, Italie) propose :

Envisager le modèle éthique de la sagesse pratique pour compenser les limites de cette approche. La sagesse pratique remonte à Aristote, était au cœur de l’humanisme européen primitif et renaît aujourd’hui avec l’éthique de la vertu. La phronèse est la capacité à gérer les imprévus grâce à un jugement juste. Le jugement juste repose sur l’expérience, les exemples, les relations sociales, la relation entre les moyens et les fins, mais aussi sur la capacité à aiguiser sa perception et son raisonnement afin d’appliquer la règle de manière appropriée ou de trouver la règle applicable à un cas inconnu. Il s’agit d’un type de rationalité qui combine le côté psychologique et sentimental (passions, émotions, désirs) et le côté intellectuel (évaluation, jugement, choix) de l’individu.

Ainsi, du point de vue du modèle éthique de la sagesse pratique :

Le problème éthique n’est donc pas de former de mieux en mieux les machines ou de fixer des normes de programmation et de production toujours plus spécifiques, car il s’agit là d’un processus qui échappe de toute façon à tout contrôle et à toute prévision. Le problème est plutôt de savoir comment promouvoir le développement de la sagesse individuelle afin de garantir une relation « prudente » avec la technologie, précisément dans la mesure où les machines deviennent de plus en plus efficaces et omniprésentes.

Toutes les présentations sont à retrouver sur la chaîne YouTube @nhnai-network – abonnez-vous !